最近,微软和Salesforce联手发布了一项重磅研究,揭示了当前最先进的AI语言模型在多轮对话中的“致命弱点”。即使是最顶尖的模型,如GPT-4.1、Claude3.7Sonnet等,在长时间交互中也表现出了严重的可靠性问题。

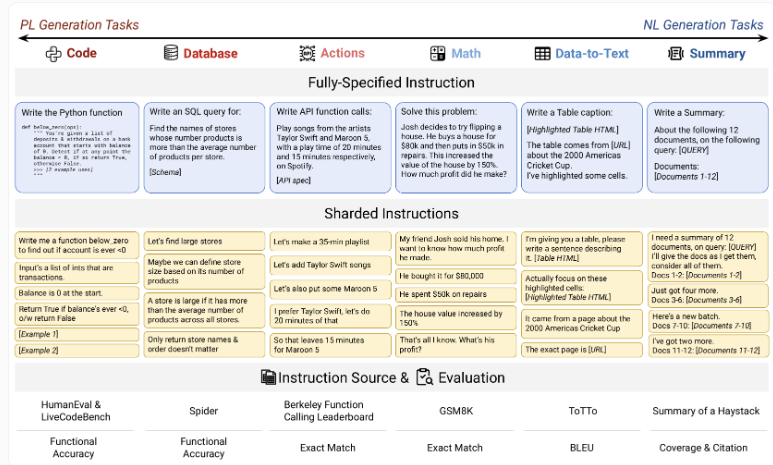

分片测试:模拟真实对话场景

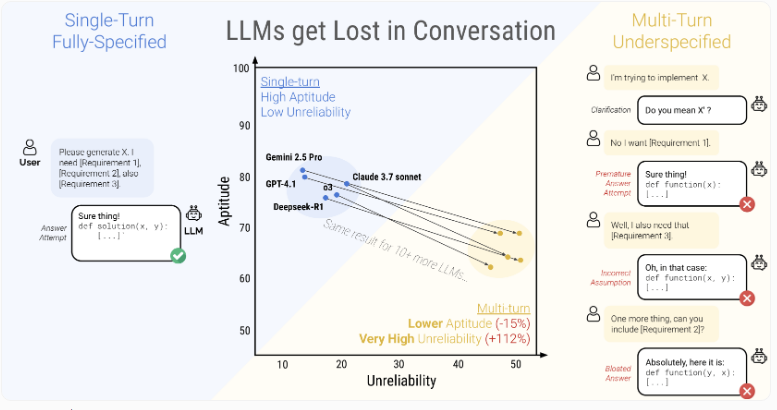

研究团队设计了一种名为“分片”的测试方法,将任务分解为多个小步骤,逐步提供信息,以模拟用户的真实需求表达过程。结果显示,AI模型的准确率从最初的90%骤降至51%,性能下降幅度高达39%!无论是开源模型还是商业大模型,无一幸免。

实验涉及90到120条指令,每条指令被拆解为更小的任务单元。结果表明,AI模型在多步骤、未明确指定的对话中容易“迷失”,导致性能显著下滑。

四大核心问题浮出水面

- 过早结论: 在未获取完整信息时匆忙下判断。

- 过度依赖历史: 即使之前回答有误,仍坚持错误逻辑。

- 信息忽略: 忽略对话中的关键细节。

- 过度详述: 提供过多不必要的细节,反而造成误导。

技术优化效果有限

研究团队尝试了多种优化策略,例如调整模型温度参数、让AI重复用户指令等,但收效甚微。唯一有效的办法是在对话开始时就提供所有必要信息。

这表明,当前的AI模型在处理复杂多轮对话时,仍存在明显短板。对于开发者而言,提升多轮对话的可靠性将是未来的重要方向。

应对策略与行业启示

针对这一问题,专家建议用户在对话偏离主题时重新开始新对话,并要求AI总结需求作为新起点。而对于开发者,则需要更加关注模型在不完整指令下的稳定性,而非单纯依赖提示技巧或参数调整。

这项研究提醒我们,AI助手的实际应用仍面临诸多挑战。未来的改进方向不仅在于提升能力,更要注重可靠性和用户体验。

[hhw123pingdao]

温馨提示:

- 请注意,下载的资源可能包含广告宣传。本站不对此提供任何担保,请用户自行甄别。

- 任何资源严禁网盘中解压缩,一经发现删除会员资格封禁IP,感谢配合。

- 压缩格式:支持 Zip、7z、Rar 等常见格式。请注意,下载后部分资源可能需要更改扩展名才能成功解压。

- 本站用户禁止分享任何违反国家法律规定的相关影像资料。

- 内容来源于网络,如若本站内容侵犯了原著者的合法权益,可联系我们进行处理,联系微信:a-000000

📝留言定制 (0)