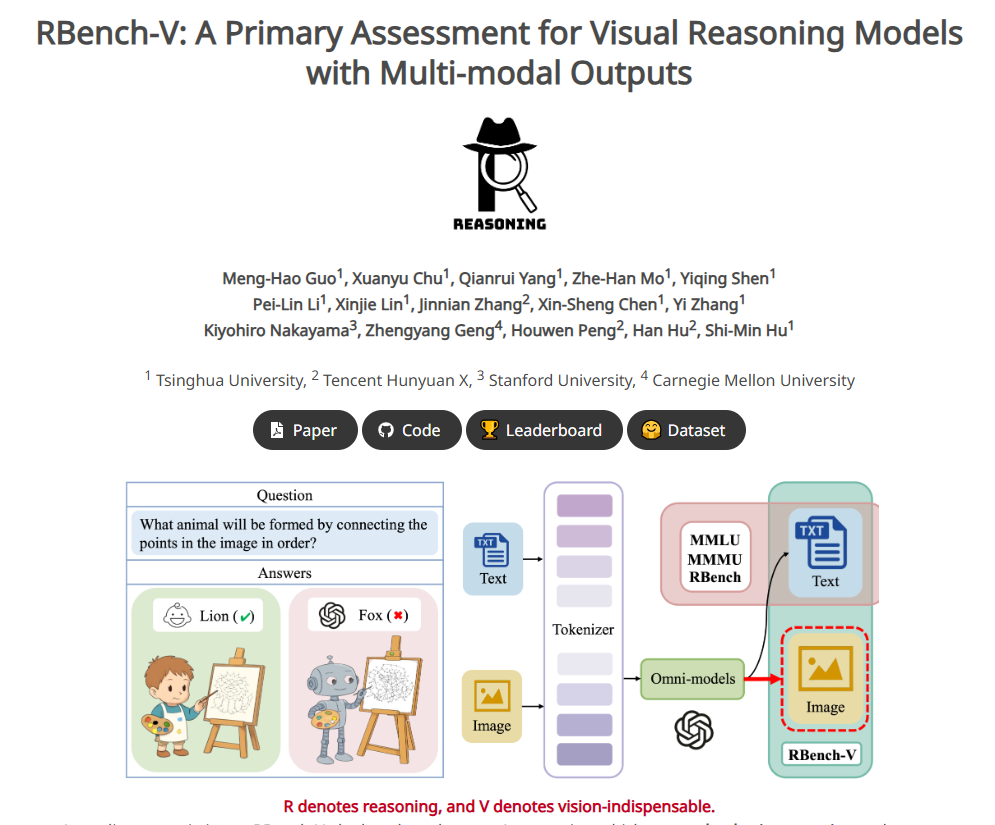

最近,清华大学、腾讯混元团队与斯坦福大学、卡耐基梅隆大学联手推出了一项重磅评估基准——RBench-V,专门用来测试多模态大模型的视觉推理能力。这项新基准填补了当前评估体系中对模型生成或修改图像能力的空白,让我们更清晰地了解这些“聪明”的AI到底有多“聪明”。

RBench-V 包含803道题目,涵盖了从几何图论到力学电磁学,再到多目标识别和路径规划等多个领域。与以往只靠文字回答的评测不同,这次要求模型通过生成或修改图像来支持推理过程。换句话说,AI需要像人类一样,通过绘制辅助线或观察图形结构来进行思考。

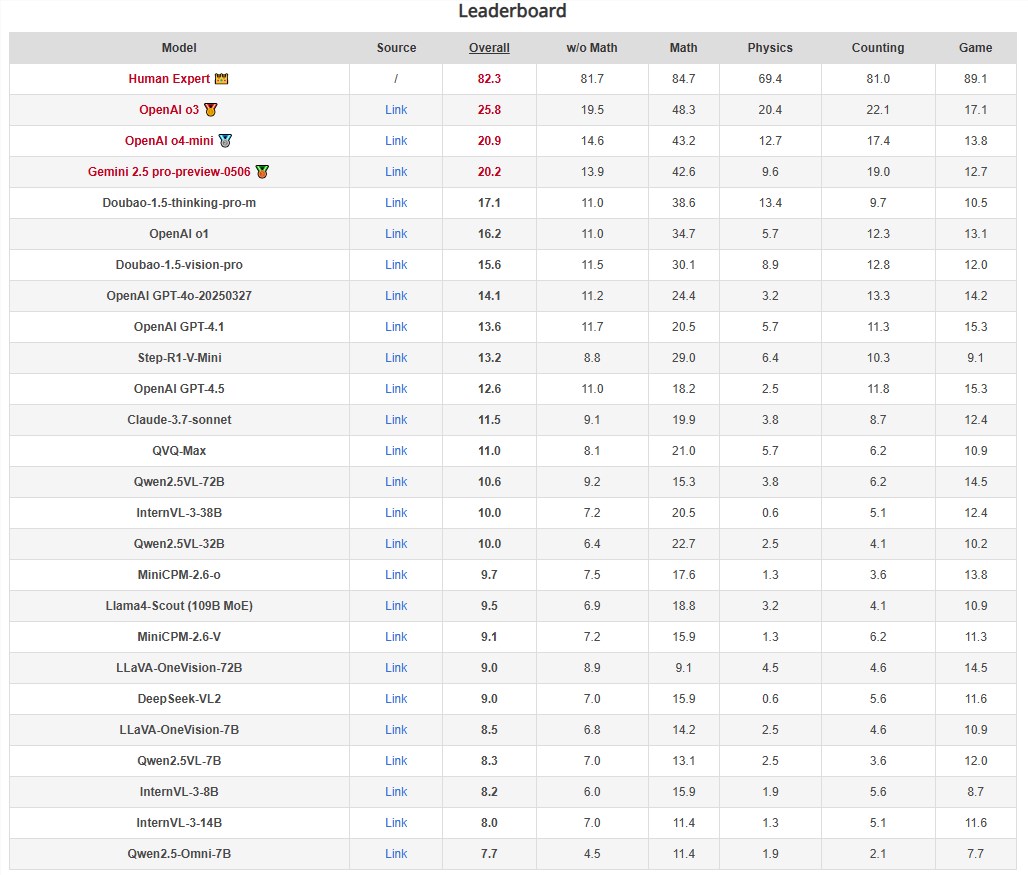

然而,测试结果却让人有点失望:即便是表现最好的o3模型,在RBench-V上的准确率也只有25.8%,而人类专家的得分高达82.3%!Google的Gemini2.5模型紧随其后,但也只拿到了20.2%的成绩。更惨的是,许多开源模型的准确率甚至在8%-10%之间,几乎等同于随机作答。

研究发现,目前的多模态大模型在处理复杂几何问题时,大多采用代数表达的方式进行文本推理,而非像人类那样通过直观的可视化方法思考。这种简化策略暴露了它们在深层理解图像信息上的不足。

研究团队认为,未来的AI模型需要具备主动生成图像的能力,以辅助推理过程,从而真正实现类人智能。他们还提到,多模态思维链和智能体推理可能是推动AI发展的关键方向。

想了解更多?可以访问项目主页:RBench-V 项目主页。

划重点:

RBench-V是评估多模态大模型视觉推理能力的新基准。

即使是顶级模型o3,也仅获得25.8%的准确率,远低于人类水平。

当前AI缺乏深层次的图像理解能力,需改进推理方式以迈向更高智能。

[hhw123pingdao]

温馨提示:

- 请注意,下载的资源可能包含广告宣传。本站不对此提供任何担保,请用户自行甄别。

- 任何资源严禁网盘中解压缩,一经发现删除会员资格封禁IP,感谢配合。

- 压缩格式:支持 Zip、7z、Rar 等常见格式。请注意,下载后部分资源可能需要更改扩展名才能成功解压。

- 本站用户禁止分享任何违反国家法律规定的相关影像资料。

- 内容来源于网络,如若本站内容侵犯了原著者的合法权益,可联系我们进行处理,联系微信:a-000000

📝留言定制 (0)